Cycle de vie, chaîne de traitement et chaîne de valeur de la donnée : Quésaco ? ; un article proposé par Galla Topalian ! (suite…)

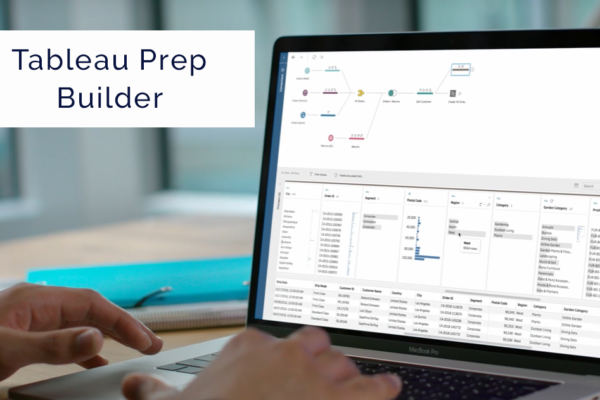

Partez à la découverte de Tableau Prep Builder, un article de blog proposé par Aya MHADHBI, Data Analyst au sein de la #SynalTeam. (suite…)

Business Intelligence : Partez à la découverte de Knowage : une solution open source, une solution renouvelée ayant hérité de toute l'histoire technologique de son prédécesseur Spago BI ! Par les... Lire la suite →

Du 12 au 19 juin, la #SynalTeam organise une formation exceptionnelle dans ses locaux ! (suite…)

Apache Spark est un framework de data processing qui permet de traiter de gros volumes de données. Spark se charge de distribuer le calcul sur plusieurs machines en utilisant principalement... Lire la suite →