Apache Spark est un framework de data processing qui permet de traiter de gros volumes de données. Spark se charge de distribuer le calcul sur plusieurs machines en utilisant principalement... Lire la suite →

Envoyé spécial au Berlin Buzzword 2017, Charly Clairmont nous livre ses premières impressions sur la capitale Allemande et nous parle des bouleversements en cours dans le monde du traitement de... Lire la suite →

Il y a quelques semaines, Talend annonçait la sortie de sa nouvelle version. Spark et big data en temps réel, intégration en continu, nouveaux connecteurs et MDM, quoi de neuf... Lire la suite →

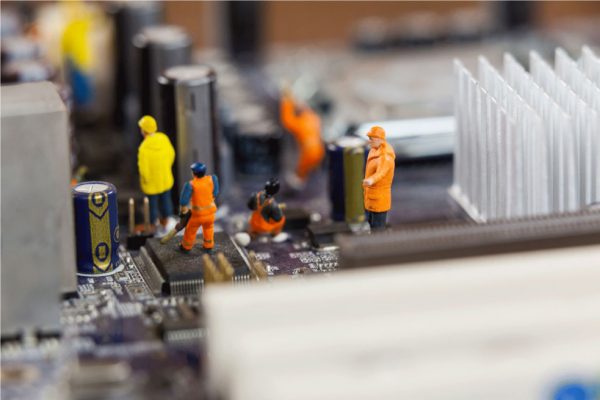

Je voulais intituler cet article "Big Data aussi simple que LAMP". J'ai vite trouvé que c'était réducteur. Depuis que Synaltic s'intéresse au Big Data, j'ai toujours imaginé qu'il fallait que... Lire la suite →